Indice

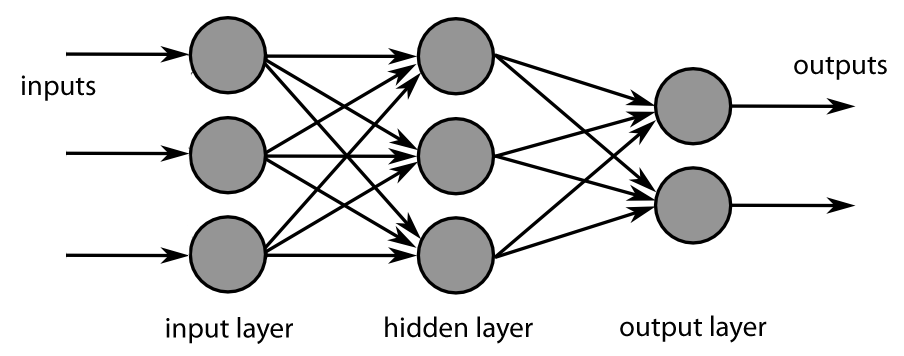

Lo scopo di ciascun nodo nelle reti neurali consiste nell'elaborazione di valori di input in entrata che restituiscono un output rielaborato nello strato successivo della rete.

Ciascun nodo della rete riceve in input dei valori che vengono immagazzinati in variabili, le quali connettendosi ad altri nodi della rete rielaborano questi valori per restituire un output che si basa sul peso $w$ delle loro connessioni.

L'operazione di combinazione di tali valori è data da una funzione di attivazione che deve fornire in output un intervallo di valori compreso tra {0, 1}; valori che devono fornire un output vicino ad $1$ quando vengono adeguatamente stimolati (effetto soglia), per poter propagare l'attività all'interno della rete, e $0$ quando non devono essere attivati.

Se si considera un singolo neurone, quali possono essere le scelte migliori per poter calcolare il peso $w$ e il bias $b$?

Per poter affrontare un processo di questo tipo step by step, avremo bisogno di una funzione che progressivamente cambia il proprio output da $0$ a $1$.

1. Funzione di Attivazione Sigmoide

La funzione di attivazione Sigmoide è definita in questo modo:

$$sigma (x) = frac{1}{1+e^{-x}} $$

Un neurone può utilizzare una funzione sigmoide per calcolare una funzione non lineare $sigma (z = wx + b)$. Se il valore di $z = wx + b$, dove se il valore è positivo e molto grande, avremo che $e^{-z} ightarrow 0$ e $sigma(z) ightarrow 1$. Mentre se abbiamo un valore molto grande negativo avremo che $e^{-z} ightarrow infty$ e $sigma(z) ightarrow 0$.

Un neurone con funzione di attivazione a sigmoide ha un comportamento molto simile al perceptron, e valori come ad esempio 0.4567 o 0.3789 sono legittimi.

2. Funzione di Attivazione ReLU

La funzione di attivazione sigmoide non è l'unico tipo di attivazione smooth utilizzata dalle reti neurali. Recente una funzione molto semplice chiamata rectified linear unit (ReLU) è diventata molto popolare poiché genere dei risultati molto soddisfacenti.

Una funzione ReLU è definita in questo modo:

$$ f(x) = max (0, .x) $$

Questo di tipo di funzione di attivazione resta a $0$ per i valori negativi, mentre cresce linearmente per i valori positivi.

Conclusione

Sigmoide e ReLU sono generalmente chiamate nelle reti neurali funzioni di attivazione.